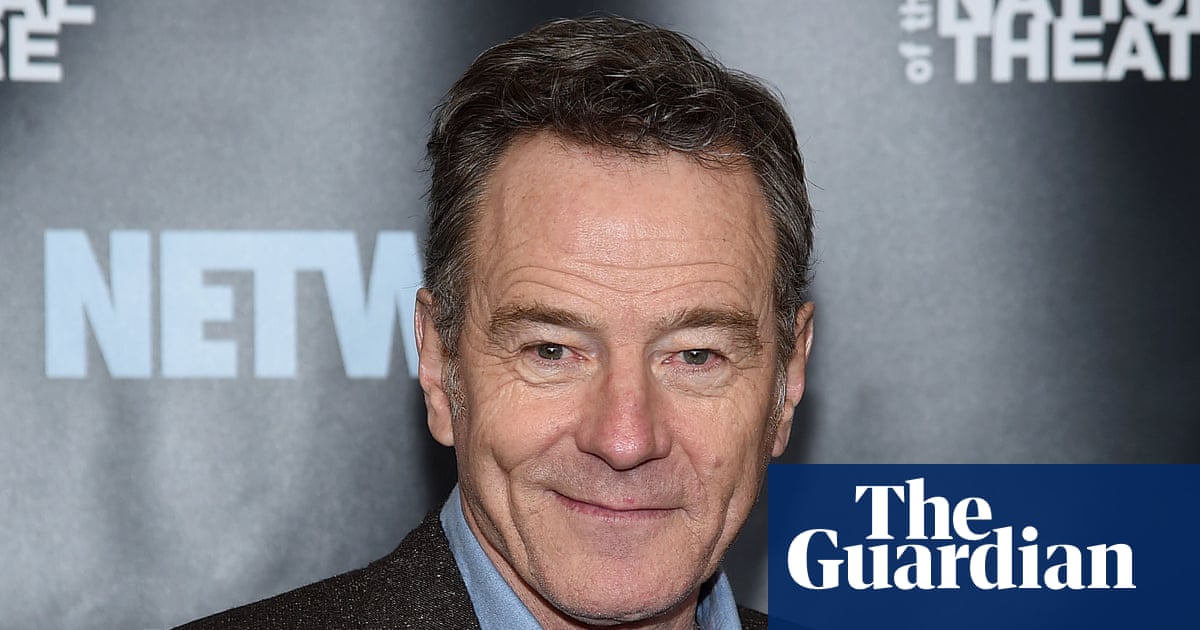

Bryan Cranston ha dicho que está "agradecido" a OpenAI por tomar medidas contra los deepfakes de él mismo en su plataforma de video con IA generativa, Sora 2. Esto pasó después de que algunos usuarios pudieran generar su voz y apariencia sin su permiso.

La estrella de Breaking Bad contactó con el sindicato de actores Sag-Aftra con sus preocupaciones cuando usuarios de Sora 2 lograron crear su imagen durante la fase de lanzamiento de la aplicación. El 11 de octubre, el periódico LA Times describió un video de Sora 2 en el que "un Michael Jackson sintético se hace un selfie con una imagen de Bryan Cranston".

En teoría, las personas vivas deben dar su consentimiento para aparecer en Sora 2. OpenAI ha declarado desde el lanzamiento que toma "medidas para bloquear las representaciones de figuras públicas" y que tiene "barreras de protección para asegurar que tu voz e imagen se usen con tu permiso".

Sin embargo, cuando Sora 2 se lanzó, varias publicaciones como el Wall Street Journal, the Hollywood Reporter y el LA Times informaron de una gran enfado en Hollywood. Esto ocurrió porque OpenAI supuestamente dijo a varias agencias y estudios que, si no querían que su material protegido por derechos de autor se replicara, tenían que optar por no participar, en lugar de dar un consentimiento activo.

OpenAI negó estos informes, diciéndole al LA Times que siempre fue su intención dar a las figuras públicas control sobre el uso de su imagen.

El lunes, Cranston publicó un comunicado a través de Sag-Aftra, agradeciendo a OpenAI por "mejorar sus medidas de seguridad" para evitar que los usuarios vuelvan a generar su imagen. "Me preocupaba mucho, no solo por mí, sino por todos los actores cuyo trabajo e identidad pueden ser mal utilizados de esta manera," dijo Cranston. "Estoy agradecido a OpenAI por su política y por mejorar sus protecciones, y espero que ellos y todas las empresas involucradas en este trabajo, respeten nuestro derecho personal y profesional a controlar la réplica de nuestra voz y apariencia."

Dos de las agencias más grandes de Hollywood, Creative Artists Agency (CAA) y United Talent Agency (UTA) – que representa a Cranston – han alertado repetidamente sobre los riesgos potenciales de Sora 2 y otras plataformas de IA generativa para sus clientes y sus carreras.

Pero el lunes, UTA y CAA firmaron una declaración conjunta con OpenAI, Sag-Aftra y la asociación de agentes, afirmando que lo que le pasó a Cranston fue un error y que todos trabajarían juntos para proteger el "derecho de los actores a decidir cómo y si pueden ser simulados."

"Mientras que desde el principio era la política de OpenAI requerir el consentimiento para el uso de la voz e imagen, OpenAI expresó su arrepentimiento por estas generaciones no intencionadas. OpenAI ha fortalecido las protecciones en torno a la réplica de voz e imagen cuando los individuos no dan su consentimiento," decía el comunicado.

El actor Sean Astin, el nuevo presidente de Sag-Aftra, advirtió que Cranston "es uno de los innumerables artistas cuya voz e imagen están en peligro de una apropiación masiva por la tecnología de replicación."

"Bryan hizo lo correcto al comunicarse con su sindicato y sus representantes profesionales para que se solucionara el problema. Este caso en concreto tiene un desenlace positivo. Me alegro de que OpenAI se haya comprometido a usar un protocolo de consentimiento, donde todos los artistas tienen la capacidad de elegir si desean participar en la explotación de su voz e imagen usando IA," dijo Astin.

"En resumen, los protocolos de consentimiento son la única manera de hacer negocios y la ley NO FAKES nos hará más seguros," añadió, refiriéndose a la ley NO FAKES que está siendo considerada por el Congreso, que busca prohibir la producción y distribución de réplicas generadas por IA de cualquier persona sin su consentimiento.

OpenAI apoya públicamente la ley No FAKES. Su CEO, Sam Altman, dijo que la compañía está "profundamente comprometida a proteger a los artistas de la apropiación indebida de su voz e imagen."

Sora 2 sí permite a los usuarios generar "figuras históricas", definidas en general como cualquier persona famosa y fallecida. Sin embargo, OpenAI ha acordado recientemente permitir que los representantes de figuras públicas "recientemente fallecidas" puedan solicitar que su imagen sea bloqueada en Sora 2.

A principios de este mes, OpenAI anunció que había "trabajado conjuntamente" con la familia de Martin Luther King Jr. y, a petición de ellos, había pausado la capacidad de representar a King en Sora 2 mientras la compañía "fortalece las protecciones para las figuras históricas".

Recientemente, Zelda Williams, la hija del difunto actor Robin Williams, suplicó a la gente que "por favor, dejara" de enviarle videos de IA de su padre. Mientras, Kelly Carlin, hija del difunto comediante George Carlin, ha calificado los videos de IA de su padre de "abrumadores y deprimentes".

Expertos legales han especulado que las plataformas de IA generativa permiten el uso de figuras históricas fallecidas para probar lo que es permitido según la ley.